Bloggen

3 ting på din hjemmeside, som du skal fikse med det samme

04.07.2017

Når jeg sidder, og analyserer hjemmesider er der mange ting der går igen. I dette indlæg vil jeg komme med 3 ting, som du kan – og skal fikse med det samme.

Disse 3 ting kan hjælpe dig med, at øge din trafik gennem bedre organisk synlighed i søgemaskinerne – men også hjælpe på dine konverteringer.

Interne søgeresultatsider

En af de ting jeg kan se, at flere og flere websites benytter sig af er søgeresultatsider.

Det er det ikke noget i vejen for, det er faktisk utrolig brugervenligt, og jeg er stor tilhænger af, at man kan søge på større sites. Sidder du på en meget stor webshop, eller et større nyhedsmedie er det nærmest essentielt, at du kan søge på hjemmesiden.

Hvis du ikke i dag gør brug af en intern søgemaskine, så vil jeg anbefale det, hvis dit website består af mere end 20 sider.

Det der dog er ærgerligt, som jeg også ser på websites, der gør brug af en intern søgemaskine er, at de har glemt at ekskluderer crawling af den. Google skriver også selv følgende:

”Brug robots.txt-filen på din webserver til at administrere din crawlertid ved at forhindre crawling af et uendeligt antal webadresser, f.eks. søgeresultatsider.”

Dette gøres som skrevet i tekstfilen robots.txt – som er en fil, der kommunikerer med søgerobotter. Her fortælles hvad der må, og ikke må crawles af dem. Filen ligger i roden af dit domæne altså her: www.hjemmeside.dk/robots.txt

For, at du udelukker søgerobotter for, at crawle dine søgeresultatsider skal du bruge kommandoen ”disallow:” efterfulgt af den variable man bruger til at søge.

Her er 2 eksempler på hvordan det kan se ud:

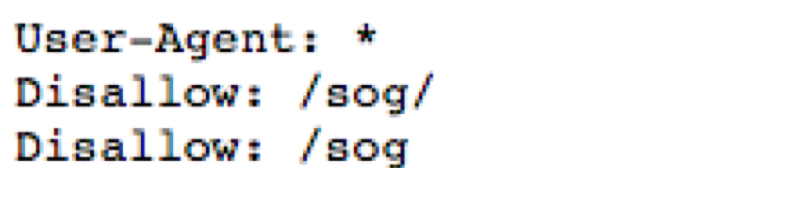

Eksempel 1

www.hjemmeside.dk/sog?fede+sko

Her er det altså /sog som skal udelukkes:

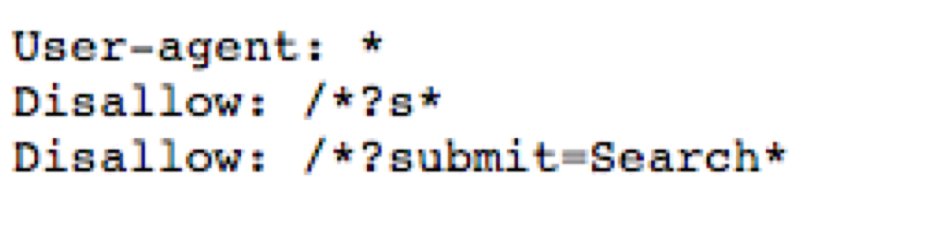

Eksempel 2

www.hjemmeside.dk/?s=fede+sko

Her er det en parameter kaldes ”?s”, der skal udelades – som egentlig kan forekomme efter alle URL’er. I robots.txt udelukker man parametre med /*varable* - det er f.eks gjort i denne robots.txt:

Duplikerede titler eller meta descriptions

Hvis du kender til SEO, så har du højst sandsynligt allerede stiftet bekendtskab med ordet ”duplicate content”. Duplicate content er en udfordring, som vi ser 9 ud af 10 hjemmesider har.

Det er ikke en straf – men forestil dig, hvis du selv gik ned på biblioteket, og tog 2 bøger hvor der er det samme indhold i, men omslaget er vidt forskelligt – det er surt, og giver ingen mening for dig, at læse begge bøger. På samme måde har søgemaskinerne – de vil oftest ikke indeksere begge sider.

Duplicate content kan forekomme på mange måder, og der findes rigtig mange indlæg om det derude. Noget af det vi ser ofte er duplikerede titler, og meta descriptions.

Det er noget, som alle mere eller mindre kan gøre noget ved.

Skriv unikke titler, og META descriptions, hvis du ikke allerede har gjort det – kør en webcrawler igennem dit site, og kontroller om du har fået det hele unikt.

Jeg kan varmt anbefale Screaming Frog SEO spider, hvis du har mindre end 500 URL’er (da det koster penge herefter).

Komprimer dine billeder

Du har sikkert hørt hvordan hele SEO branchen har været ude med riven, og prædiket om hurtige hjemmesider.

Det er bestemt noget, som jeg stadig vil ligge utrolig meget vægt på. En hurtig hjemmeside er lækker, at lande på – det giver bedre bruger engagement, større sandsynlighed for konverteringer – og ja, også bedre rankings.

En af de knapper, som vi oftest ser, at man kan skrue på for at få en hurtigere hjemmeside er, at komprimere billederne.

Billederne på hjemmesider er noget af det nemmeste, at optimere via. komprimering. Dels kan du gøre det automatisk via. Værktøjer der gør det for dig – men du kan også gøre det selv med software på din computer.

Jeg kan selv varmt anbefale Kraken Image Optimizer et billigt værktøj, der sparer dig meget tid med komprimering af billeder. Det vil nemlig via et API automatisk komprimere alle dine billeder. Hvis du bruger klassiske CMS’er som WordPress, eller Magento findes der også plugins dertil.

Tak fordi, at du brugte din tid på, at læse dette indlæg. Jeg håber, at du har kunne bruge disse 3 tips til, at komme videre. Hvis du har nogle spørgsmål må du endelig sige til.